一个字节(byte)等于8个比特(bit)这一定义,其历史和原因比较复杂,涉及早期计算机发展的多个阶段。此外,二进制作为一种数学和逻辑系统,其起源可以追溯到更早的时代。下面是对这两个问题的详细解答:

早期计算机中的字节:计算机技术早期,并没有统一的字节大小。早期的计算机系统中,字节的大小根据设计的不同而不同,可以是任何数量的比特。例如,IBM的早期机器中,字节的大小就是可变的。

标准化的需求:随着计算机技术的发展,尤其是在数据存储和传输方面,出现了对于标准化字节大小的需求。为了便于处理和交换信息,需要一个统一的、普遍接受的字节大小定义。

IBM的贡献和8比特的字节:在1960年代,IBM的System/360是首批采用8比特字节的主要计算机之一。System/360是一个非常成功的系列,对计算机行业产生了深远影响,其对字节的定义(即8比特)也随之被广泛接受。此外,美国信息交换标准码(ASCII)的出现也推动了8比特字节的标准化,因为ASCII使用7位来表示字符,而第8位通常用作奇偶校验位。

早期的二进制系统:二进制,即基于2的数学系统,其概念可以追溯到古代文明。古代印度的平面几何书籍《苏尔巴苏特拉》(公元前3世纪至公元前5世纪)中就有二进制的描述。

现代二进制的发展:现代二进制系统的主要发展是在17世纪。德国数学家莱布尼茨在1703年发表了关于二进制数的论文,正式引入了现代二进制的概念。

足够大的范围:8比特提供256个可能的值,足以表示大量的字符、符号和指令。

效率和兼容性:8是2的幂次方,符合计算机基于二进制的工作原理。这使得计算机在处理数据时更加高效。

数据处理的一致性:统一的字节大小简化了计算机系统的设计和编程。程序员和工程师可以基于这个标准来开发硬件和软件。

足够的数据范围:8比特字节能够容纳足够多的数据范围,包括完整的ASCII字符集。

简化计算机设计:围绕8比特字节的标准,计算机的硬件和软件设计可以更加简化和标准化。

兼容性:8比特的字节为字符集(如ASCII)提供了足够的空间,并允许在一个字节内包含完整的字符表示,这对于文本处理非常重要。

数据传输的效率:标准化的字节大小使得数据存储和传输更加高效和可靠。它还支持错误检测和纠正技术的发展。

技术发展的驱动:8比特字节作为标准推动了计算机技术的发展,特别是在存储和处理大量数据方面。

总之,一个字节等于8个比特这一标准的确立是计算机历史上的一个重要里程碑,它是由早期计算机的发展和标准化需求共同推动的。而二进制作为计算机科学的基础,其起源可以追溯到数千年前,但在现代计算机科学中得到了特别的应用和发展。

举例说明:SDNAND1 Gbit等于128 MByte

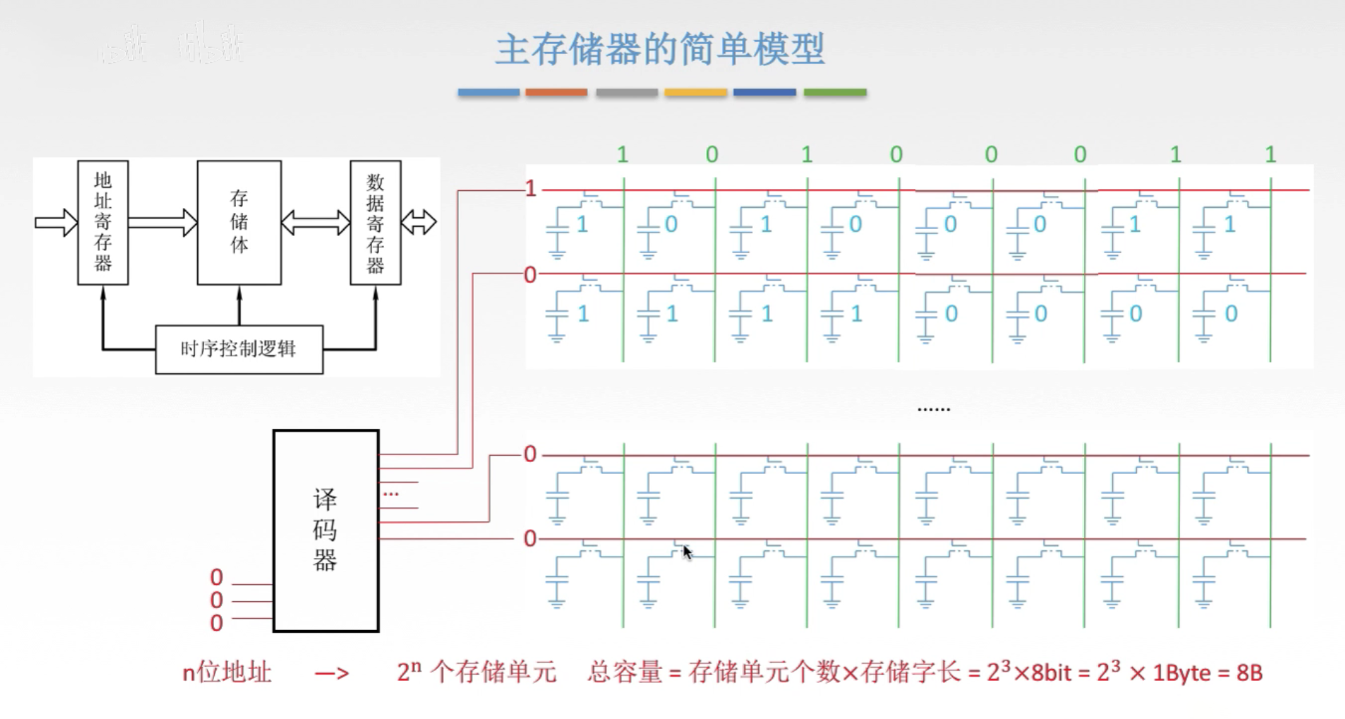

比特(bit):比特是计算机数据的基本单位。它代表一个二进制数字,即0或1。

字节(Byte):一个字节等于8比特。这是标准的数据度量单位,常用于表示计算机文件大小和内存容量。

现在来计算1 Gbit等于多少MByte:

首先,1 Gbit(Gigabit)等于 109(或1,000,000,000)比特。

由于1字节等于8比特,所以1 Gbit等于 8109 bits 字节。

将字节转换为兆字节(MByte):1 MByte = 106(或1,000,000)字节。

因此,8109 bits=125,000,000 bytes=125 MBytes。

然而,有时我们也使用二进制的度量单位(而不是十进制)。在这种情况下:

1 Gbit = 230 bits = 1,073,741,824 bits。1 Gbit = 比特 = 230 1,073,741,824 比特。

因此,1 Gbit = 81,073,741,824 bits=134,217,728 bytes。

以二进制度量,1 MByte = 220 bytes = 1,048,576 bytes。以二进制度量,1 MByte = bytes = 220 1,048,576 bytes。

所以,1 Gbit = 1,048,576 bytes/MByte134,217,728 bytes≈128 MBytes。

这解释了为什么在二进制度量中,1 Gbit等于大约128 MByte。这种度量在计算机科学中非常常见,特别是在处理存储和内存容量时。

上图说明了 1 字节如何等于 8 位。每个位都表示为表示字节的较大块中的较小部分,并且这些位以二进制序列进行标记,以演示字节的组成。

上一篇:sdnand是什么意思

电话:176-6539-0767

Q Q:135-0379-986

邮箱:xcz@xczmemory.com

地址:深圳市南山区后海大道1021号C座